Gestión de la IA a escala puede ser un desafío, pero las herramientas de orquestación adecuadas pueden simplificar los flujos de trabajo, reducir los costos, y garantizar el cumplimiento. Esta es una guía rápida de cinco plataformas confiables que ayudan a las empresas a optimizar las operaciones de IA:

Las herramientas de orquestación de IA ahorran tiempo y recursos al automatizar la implementación y la supervisión. También garantizan la gobernanza y el cumplimiento, reduciendo los riesgos relacionados con la evolución de las normativas. Ya sea que esté ampliando las LLM o gestionando los procesos de aprendizaje automático, estas plataformas proporcionan la estructura necesaria para crecer con confianza.

Estas herramientas simplifican las operaciones de IA, lo que ayuda a las empresas a centrarse en la escalabilidad y la innovación, a la vez que mantienen los costes y los riesgos bajo control.

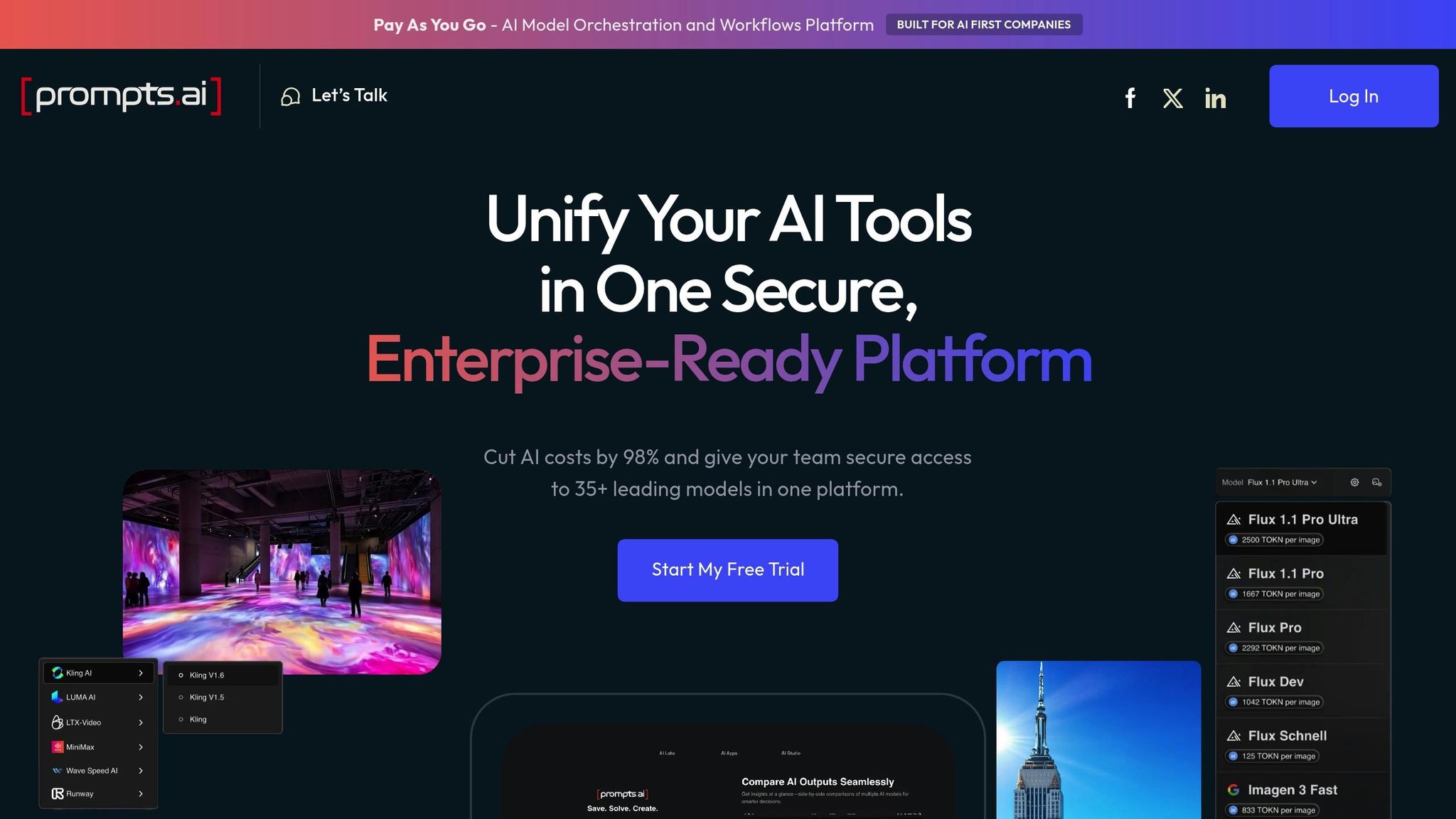

Prompts.ai es una potente plataforma de orquestación de IA de nivel empresarial que reúne más de 35 modelos lingüísticos de gran tamaño líderes - como GPT-5, Claude, Llama, y Géminis - en un sistema unificado y seguro. Al consolidar estos modelos, la plataforma elimina el desorden de múltiples herramientas, lo que facilita a las organizaciones la gestión y el despliegue de soluciones de inteligencia artificial en varios departamentos.

Creado para crecer con sus necesidades, prompts.ai admite la incorporación perfecta de modelos, usuarios y equipos. Su sólida arquitectura, combinada con las herramientas FinOps en tiempo real, garantiza un rendimiento uniforme y, al mismo tiempo, ofrece información útil para optimizar los recursos.

La interfaz de Prompts.ai está diseñada para funcionar en armonía con las herramientas de IA modernas y las pilas de tecnología existentes. El sistema de créditos TOKN de pago por uso de la plataforma hace que los gastos sean más transparentes y vincula los costos directamente con el uso, lo que simplifica tanto la presupuestación como las adquisiciones.

Teniendo en cuenta la evolución de las normativas federales, prompts.ai proporciona herramientas de gobierno de nivel empresarial y registros de auditoría detallados que son fundamentales para el cumplimiento. Su sólido marco de seguridad garantiza que los datos confidenciales permanezcan bajo el control de la organización, mientras que los controles de acceso basados en funciones imponen políticas estrictas para mantener la integridad de los datos en todos los flujos de trabajo.

Las herramientas FinOps en tiempo real brindan a los directores financieros y líderes de TI una visibilidad clara de los gastos, vinculando los costos con resultados medibles. Este enfoque puede conducir a una impresionante Reducción del 98% en los gastos de software de IA.

La eficacia de la plataforma no ha pasado desapercibida. Genai.works ha nombrado a prompts.ai la mejor plataforma de IA para la automatización y la resolución de problemas empresariales. Además, las opiniones de los usuarios en el sitio web prompts.ai reflejan constantemente un alto grado de satisfacción, con puntuaciones de 4,8, 4,9 y 5,0. Gracias a sus completas funciones, prompts.ai establece un estándar muy alto cuando analizamos otras herramientas de orquestación.

Kubeflow es una plataforma de código abierto diseñada para agilizar los flujos de trabajo de aprendizaje automático en Kubernetes. Creada originalmente por Google, simplifica el proceso de ejecución de tareas de aprendizaje automático en entornos contenerizados, lo que ofrece portabilidad, escalabilidad y facilidad de administración. Al integrarse a la perfección con Kubernetes, Kubeflow ayuda a las organizaciones a maximizar su infraestructura existente, lo que la convierte en una herramienta poderosa para las implementaciones modernas de IA.

Basado en Kubernetes, Kubeflow se destaca en el escalado horizontal. Distribuye automáticamente las tareas de aprendizaje automático en varios nodos, ya sea que estés realizando pequeños experimentos o implementando sistemas de producción a gran escala. La plataforma es compatible con marcos populares como TensorFlow y PyTorch, lo que garantiza un procesamiento eficiente incluso de conjuntos de datos masivos.

Kubeflow divide los flujos de trabajo complejos en pasos más pequeños e independientes. Cada componente se ejecuta en su propio contenedor, por lo que si una parte falla, no interrumpirá todo el proceso. Este enfoque modular garantiza un rendimiento uniforme en todos los entornos, desde las configuraciones de desarrollo locales hasta los clústeres de producción expansivos.

Una de las características más destacadas de Kubeflow es su capacidad de trabajar sin problemas con las herramientas de aprendizaje automático más utilizadas. Es compatible con los cuadernos Jupyter, TensorFlow y PyTorch, lo que permite a los científicos de datos utilizar herramientas conocidas y, al mismo tiempo, aprovechar las capacidades de orquestación de Kubeflow. Su SDK Pipeline, que usa Python, permite a los equipos definir flujos de trabajo y ejecutar experimentos en varios marcos en un entorno unificado.

Kubeflow también se integra con las principales soluciones de almacenamiento en la nube, como Amazon S3, Google Cloud Storage y Azure Blob Storage. Esta compatibilidad permite a los equipos mantener su infraestructura de datos existente y, al mismo tiempo, crear flujos de trabajo de IA interoperables.

Kubeflow garantiza la seguridad y el cumplimiento al aprovechar el control de acceso basado en roles (RBAC) integrado de Kubernetes. Mantiene registros de auditoría detallados de las ejecuciones en proceso, las implementaciones y las actividades de los usuarios, lo que ayuda a las organizaciones a cumplir los requisitos reglamentarios. Además, sus herramientas de seguimiento de experimentos crean registros detallados del desarrollo del modelo, lo que contribuye a la reproducibilidad y la transparencia.

La arquitectura de Kubeflow admite la implementación en clústeres de Kubernetes optimizados para una computación rentable. Al utilizar las capacidades de escalado automático de Kubernetes, las cargas de trabajo pueden ajustarse de forma dinámica para satisfacer las demandas de procesamiento, lo que reduce el consumo innecesario de recursos y los costos operativos.

La plataforma también cuenta con almacenamiento en caché de canalización, que reutiliza salidas idénticas de ejecuciones anteriores. Esto reduce tanto el tiempo de procesamiento como los gastos durante los ciclos de desarrollo iterativos, lo que convierte a Kubeflow en una opción eficiente para proyectos de IA a largo plazo.

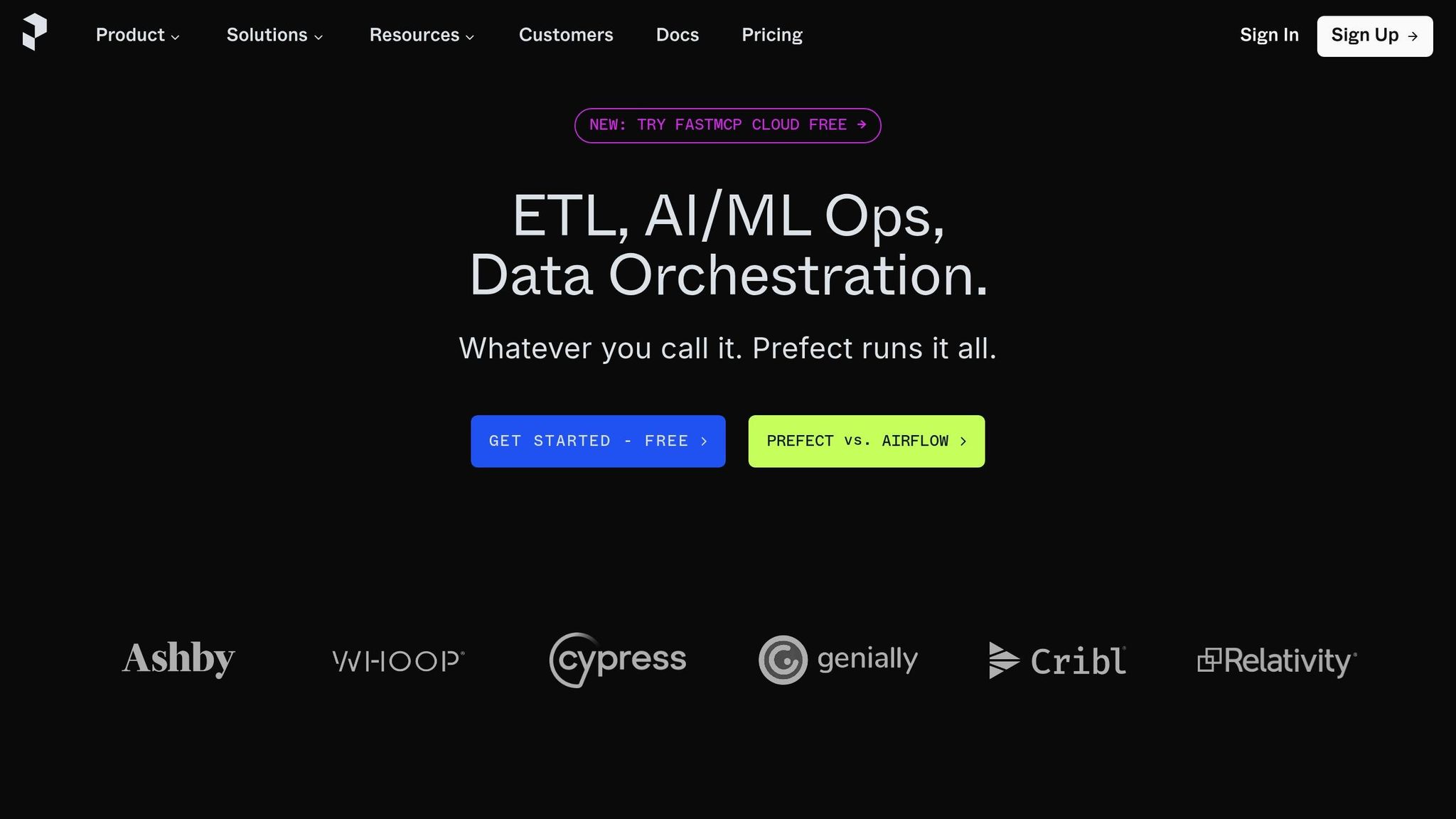

Prefect es una plataforma moderna para orquestación de flujos de trabajo, diseñado para ayudar a los equipos a crear, gestionar y supervisar los flujos de trabajo de datos con Python. Permite a los científicos e ingenieros de datos optimizar con facilidad los procesos complejos de modelos de IA.

Prefect asegura los flujos de trabajo funcionan sin problemas, interviniendo solo cuando se producen fallos o anomalías, lo que reduce al mínimo los gastos operativos.

Prefect admite el escalado horizontal y vertical a través de su modelo de ejecución distribuida. Gestiona de manera eficiente los flujos de trabajo en múltiples máquinas, contenedores o entornos de nube. Esta flexibilidad permite a los equipos pasar sin esfuerzo de los entornos de desarrollo local a los de producción en los que se gestionan numerosas tareas simultáneas. Al distribuir las tareas de manera eficaz, Prefect ayuda a reducir el tiempo de procesamiento y aumenta la eficiencia general.

Prefect funciona a la perfección con bibliotecas de aprendizaje automático populares como TensorFlow, PyTorch, scikit-learn y Hugging Face Transformers. Como los flujos de trabajo se escriben en Python, los científicos de datos pueden incorporar directamente su código modelo existente sin esfuerzo adicional. Además, Prefect se integra con las principales plataformas en la nube, como AWS SageMaker, Plataforma de IA de Google Cloud, y Aprendizaje automático de Azure, lo que simplifica tareas como el aprovisionamiento de recursos y la autenticación. Estas integraciones también permiten una mejor gestión y supervisión de los flujos de trabajo.

Prefect ofrece herramientas sólidas para el seguimiento y la gestión de las ejecuciones del flujo de trabajo. Mantiene registros de auditoría detallados que registran el rendimiento de las tareas y las interacciones con los datos, lo que contribuye a las revisiones operativas y de cumplimiento. El control de acceso basado en roles garantiza que los miembros del equipo tengan los permisos correctos, mientras que el control de versiones del flujo de trabajo simplifica la administración de las actualizaciones y los cambios a lo largo del tiempo.

Prefect está diseñado para optimizar el uso de los recursos mediante la ejecución de tareas solo cuando es necesario. Este enfoque ayuda a controlar los costos en las operaciones de IA a gran escala al minimizar los ciclos de cómputos innecesarios, lo que lo convierte en una herramienta valiosa para administrar los presupuestos de manera efectiva.

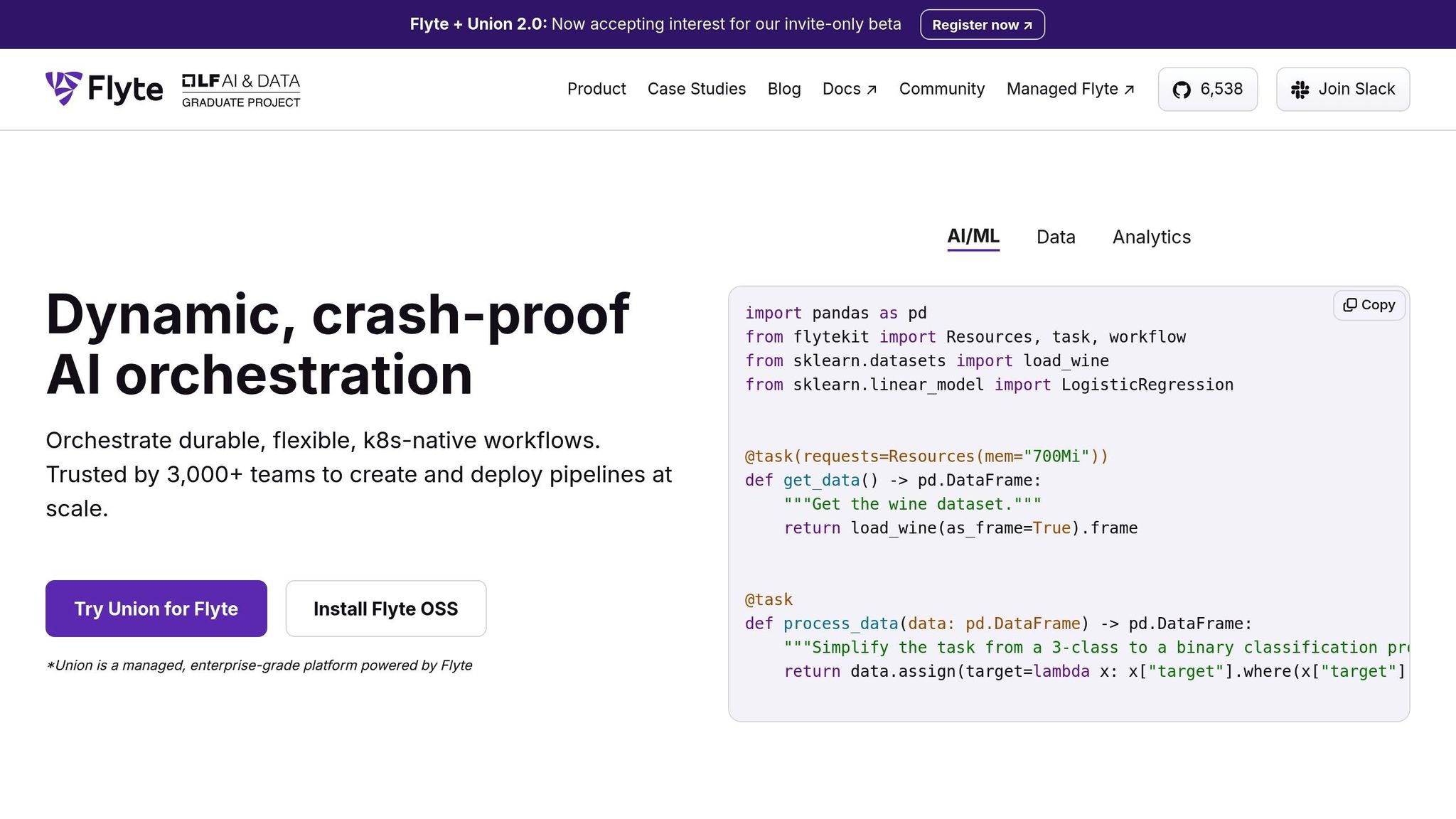

Flyte es una plataforma de código abierto diseñada para organizar los flujos de trabajo para tareas de aprendizaje automático y de datos. Desarrollado por Lyft, hace hincapié en la seguridad de los tipos y la reproducibilidad, por lo que es ideal para gestionar a escala complejos canales de modelos de IA.

Una característica destacada de Flyte es su capacidad para rastrear el linaje de datos. Cada ejecución de flujo de trabajo captura metadatos detallados sobre las entradas, las salidas y las transformaciones, lo que simplifica la depuración y garantiza que los resultados se puedan reproducir de forma fiable en diferentes entornos.

Flyte se basa en Kubernetes, lo que le permite escalar los recursos automáticamente en función de las demandas de la carga de trabajo. Puede gestionar cualquier cosa, desde tareas sencillas de procesamiento de datos hasta intrincados procesos de aprendizaje automático de varias etapas con cientos de tareas paralelas.

La plataforma utiliza un método de evaluación perezoso, que ejecuta las tareas solo cuando se cumplen todas las dependencias. Esto reduce la sobrecarga computacional y optimiza la eficiencia de la canalización. El planificador de Flyte asigna los recursos de manera inteligente, lo que garantiza que las tareas con muchos recursos informáticos obtengan la potencia que necesitan y, al mismo tiempo, evita conflictos de recursos.

Flyte también admite despliegues de clústeres múltiples, lo que permite distribuir las cargas de trabajo en varias regiones de la nube o incluso en configuraciones locales. Esto es particularmente útil para las organizaciones que trabajan con conjuntos de datos dispersos geográficamente o que necesitan cumplir con las normas de residencia de datos. En combinación con sus excelentes capacidades de integración, Flyte es ideal para operaciones de inteligencia artificial y aprendizaje automático a gran escala.

Flyte se integra sin problemas con las herramientas populares de aprendizaje automático a través de su FlyteKit Python SDK. Los científicos de datos pueden crear flujos de trabajo utilizando bibliotecas conocidas como TensorFlow, PyTorch, XGBoost y scikit-learn, todo dentro de un entorno basado en Python.

La plataforma también incluye complementos para servicios como AWS SageMaker, Google Cloud AI Platform y Azure ML, que administran automáticamente la autenticación, el aprovisionamiento de recursos y la supervisión de trabajos.

El enfoque en contenedores de Flyte garantiza que todos los componentes del flujo de trabajo se ejecuten en un entorno aislado con dependencias claramente definidas. Cada tarea puede especificar su propia imagen de Docker, bibliotecas de Python y necesidades de recursos. Esta configuración elimina el problema común de «funciona en mi máquina», lo que hace que las implementaciones sean más consistentes y confiables. Esta sólida integración también respalda las capacidades de gobierno de Flyte.

Flyte proporciona pistas de auditoría detalladas y un seguimiento del linaje de datos para cada ejecución de flujo de trabajo. Los registros capturan qué datos se procesaron, qué transformaciones se aplicaron y quién inició el flujo de trabajo, lo que los hace especialmente valiosos para los sectores con requisitos reglamentarios estrictos.

La plataforma incluye un control de acceso basado en roles (RBAC) de varios niveles, que permite a los administradores administrar los permisos para crear, modificar o ejecutar flujos de trabajo.

El control de versiones es una característica principal de Flyte. Cada flujo de trabajo, tarea y plan de lanzamiento se versiona automáticamente, lo que facilita volver a las iteraciones anteriores o comparar diferentes versiones de una canalización. Este control de versiones también se extiende al código subyacente, las dependencias y los entornos de ejecución, lo que garantiza una trazabilidad total.

Flyte está diseñado para mantener los costos bajo control. Utiliza instancias puntuales para reducir los gastos informáticos y proporciona métricas detalladas para ayudar a identificar los cuellos de botella de los recursos. Además, la plataforma cuenta con un mecanismo de almacenamiento en caché que reutiliza los resultados de las tareas ejecutadas anteriormente cuando las entradas permanecen sin cambios.

Las solicitudes y los límites de recursos se pueden establecer para tareas individuales, lo que evita que un solo trabajo monopolice los recursos del clúster. La función de almacenamiento en caché de Flyte es particularmente útil para los flujos de trabajo iterativos, en los que los científicos de datos suelen volver a ejecutar partes de sus procesos con pequeños ajustes. Al reutilizar los resultados, reduce significativamente tanto el tiempo como los costos de cálculo, lo que convierte a Flyte en una opción eficiente para la orquestación de la IA a nivel empresarial.

Cerrando la lista está Apache Airflow, una herramienta de código abierto bien establecida diseñada para administrar todo el ciclo de vida del aprendizaje automático. Gracias a su capacidad para organizar flujos de trabajo complejos, Apache Airflow se integra perfectamente con herramientas populares como TensorFlow, PyTorch, AWS SageMaker, Google Cloud AI Platform y Azure Machine Learning.

Lo que diferencia a Apache Airflow es su capacidad para gestionar flujos de trabajo avanzados, incluidos los de la IA generativa. Es compatible con procesos como la integración de modelos, bases de datos vectoriales y computación distribuida, lo que lo convierte en una potente opción para agilizar la generación aumentada por recuperación en aplicaciones de IA generativa.

Elija la herramienta de orquestación que mejor se adapte a sus necesidades, experiencia y objetivos. A continuación, se muestra una comparación de las áreas clave de rendimiento en las plataformas más populares.

En esta tabla se destacan las principales características de cada plataforma. A continuación, analizamos los puntos fuertes únicos de cada herramienta.

Desglose de las principales fortalezas:

Su decisión debe depender de lo que más le importe: acceso inmediato a la IA (prompts.ai), control integral de ML (Kubeflow), simplicidad apta para desarrolladores (Prefecto), reproducibilidad centrada en la investigación (Flyte), o amplia flexibilidad de flujo de trabajo (Flujo de aire de Apache).

La rápida evolución de la orquestación de la IA está transformando la forma en que las organizaciones gestionan los flujos de trabajo complejos y exige soluciones que prioricen la fiabilidad, la gobernanza y la escalabilidad. Las cinco herramientas que se destacan aquí muestran una variedad de estrategias para gestionar los modelos de IA y las canalizaciones de datos en los entornos de producción.

La confiabilidad no es negociable: cualquier tiempo de inactividad puede traducirse directamente en una pérdida de ingresos. Cada herramienta aborda este desafío de manera diferente, ya sea a través de la infraestructura de nivel empresarial de prompts.ai, en la que confían las empresas de la lista Fortune 500, o de las comprobadas capacidades de gestión del flujo de trabajo de Apache Airflow. Estas funciones garantizan un funcionamiento fluido y, al mismo tiempo, minimizan las interrupciones.

La gobernanza es igualmente crítica, especialmente para las empresas que manejan datos confidenciales. Funciones como el seguimiento, los registros de auditoría y los controles de acceso ayudan a mantener la responsabilidad y el cumplimiento. Al evaluar las plataformas, ten en cuenta cómo gestionan el linaje de datos, los permisos de usuario y los requisitos normativos específicos de tu sector.

La escalabilidad es otro factor clave, ya que los modelos de IA y los volúmenes de datos siguen creciendo. Una plataforma de orquestación bien elegida puede ayudar a gestionar estas demandas de manera eficiente, reduciendo los costos de software y respaldando la eficiencia operativa a largo plazo.

La selección de la herramienta de orquestación adecuada requiere equilibrar las capacidades técnicas con las obligaciones reglamentarias. Tenga en cuenta la experiencia, la complejidad del flujo de trabajo y las necesidades de cumplimiento de su equipo. Para los equipos con recursos de DevOps limitados, las plataformas nativas de la nube pueden ser la opción más práctica. Mientras tanto, las organizaciones con requisitos estrictos de soberanía de datos pueden optar por soluciones autohospedadas.

La elección que haga hoy tendrá un impacto duradero en sus capacidades de IA. Tómese el tiempo para evaluar sus necesidades, probar las plataformas preseleccionadas mediante proyectos piloto y tener en cuenta tanto las prioridades actuales como el crecimiento futuro. Estas herramientas no solo agilizan la implementación, sino que también proporcionan los marcos operativos y de cumplimiento esenciales para las implementaciones exitosas de la IA.

Las herramientas de orquestación de modelos de IA simplifican el cumplimiento y la gobernanza al centralizar las tareas críticas, como la aplicación de políticas, la gestión del acceso y la supervisión de riesgos. Al automatizar estos flujos de trabajo, garantizan que los modelos de IA cumplan con las regulaciones del sector, lo que hace que el proceso de revisión y aprobación de los cambios sea más eficiente y, al mismo tiempo, mantenga una transparencia total.

Estas herramientas también respaldan la supervisión continua de los sistemas de IA, lo que permite a las organizaciones detectar y abordar rápidamente los posibles desafíos de cumplimiento. Al minimizar los riesgos y garantizar el cumplimiento de las normas reglamentarias, ofrecen un sistema fiable para gestionar la IA de manera responsable y eficiente.

Para las empresas con equipos de DevOps más pequeños, seleccionar una herramienta de orquestación de modelos de IA que priorice sencillez, automatización, y integración fluida puede marcar la diferencia. Estas funciones minimizan la necesidad de contar con una amplia experiencia técnica, lo que permite a los equipos concentrarse en lograr resultados impactantes.

Al evaluar las herramientas, tenga en cuenta aquellas que:

Centrarse en estos aspectos garantiza que las empresas puedan implementar y gestionar los flujos de trabajo de IA de forma eficaz sin agotar los recursos existentes.

Las herramientas de orquestación de IA están diseñadas para funcionar sin problemas con una amplia gama de marcos de AI/ML y plataformas de nube líderes, como AWS, GCP y Azure. Aprovechan APIs, SDKs, o integraciones nativas para gestionar tareas críticas como la implementación, la supervisión y el escalado de modelos en diversos entornos.

La mayoría de las plataformas también admiten despliegues en contenedores, lo que simplifica el proceso de ejecución de los flujos de trabajo en la infraestructura de nube. Este enfoque proporciona la adaptabilidad y la escalabilidad que los equipos necesitan para optimizar sus operaciones de IA sin tener que revisar sus sistemas actuales.