إدارة الذكاء الاصطناعي على نطاق واسع يمكن أن تكون صعبة، ولكن أدوات التنسيق الصحيحة يمكن أن تبسط سير العمل، خفض التكاليف، وضمان الامتثال. فيما يلي دليل سريع لخمس منصات موثوقة تساعد الشركات على تبسيط عمليات الذكاء الاصطناعي:

تعمل أدوات تنسيق الذكاء الاصطناعي على توفير الوقت والموارد من خلال التشغيل الآلي للنشر والمراقبة. كما أنها تضمن الحوكمة والامتثال، مما يقلل المخاطر المرتبطة باللوائح المتطورة. سواء كنت تقوم بتوسيع نطاق LLMs أو إدارة خطوط أنابيب ML، توفر هذه المنصات البنية اللازمة للنمو بثقة.

تعمل هذه الأدوات على تبسيط عمليات الذكاء الاصطناعي، مما يساعد الشركات على التركيز على التوسع والابتكار مع الحفاظ على التكاليف والمخاطر تحت السيطرة.

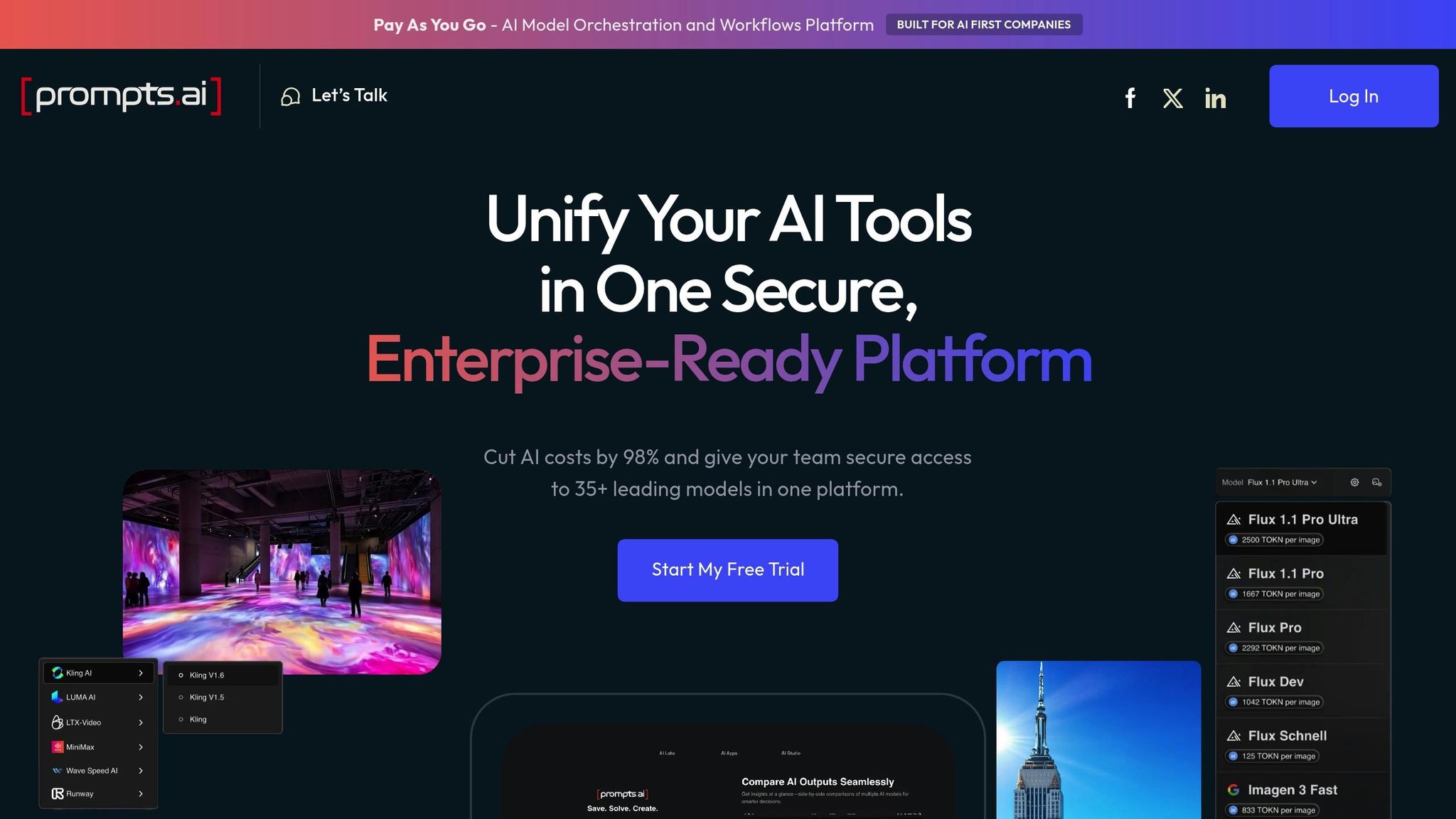

Prompts.ai عبارة عن منصة تنسيق قوية للذكاء الاصطناعي على مستوى المؤسسة تجمع معًا أكثر من 35 نموذجًا رائدًا للغات الكبيرة - مثل GPT-5، كلود، لاما، و الجوزاء - في نظام واحد آمن وموحد. ومن خلال دمج هذه النماذج، تعمل المنصة على التخلص من فوضى الأدوات المتعددة، مما يسهل على المؤسسات إدارة حلول الذكاء الاصطناعي ونشرها عبر الإدارات المختلفة.

تم تصميم prompts.ai لينمو وفقًا لاحتياجاتك، وهو يدعم الإضافة السلسة للنماذج والمستخدمين والفرق. تضمن بنيتها القوية، المقترنة بأدوات FinOps في الوقت الفعلي، أداءً ثابتًا مع تقديم رؤى قابلة للتنفيذ لتحسين الموارد.

تم تصميم واجهة Prompts.ai للعمل بانسجام مع أدوات الذكاء الاصطناعي الحديثة ومكدسات التكنولوجيا الحالية. يعمل نظام أرصدة TOKN للدفع أولاً بأول في المنصة على جعل الإنفاق أكثر شفافية وربط التكاليف مباشرة بالاستخدام، مما يبسط كلاً من الميزانية والمشتريات.

مع وضع اللوائح الفيدرالية المتطورة في الاعتبار، توفر prompts.ai أدوات حوكمة على مستوى المؤسسة ومسارات تدقيق مفصلة ضرورية للامتثال. يضمن إطار الأمان القوي الخاص بها بقاء البيانات الحساسة تحت سيطرة المؤسسة، بينما تفرض ضوابط الوصول القائمة على الأدوار سياسات صارمة للحفاظ على سلامة البيانات عبر عمليات سير العمل.

توفر أدوات FinOps في الوقت الفعلي للمديرين الماليين وقادة تكنولوجيا المعلومات رؤية واضحة للإنفاق، وربط التكاليف بالنتائج القابلة للقياس. هذا النهج يمكن أن يؤدي إلى مثير للإعجاب انخفاض بنسبة 98% في نفقات برامج الذكاء الاصطناعي.

لم تمر فعالية المنصة دون أن يلاحظها أحد. جيناي. ووركس اختارت prompts.ai أفضل منصة للذكاء الاصطناعي لحل مشكلات المؤسسات والأتمتة. بالإضافة إلى ذلك، تعكس مراجعات المستخدمين على موقع prompts.ai باستمرار الرضا العالي، مع تقييمات 4.8 و 4.9 و 5.0. بفضل ميزاته الشاملة، يضع prompts.ai معيارًا عاليًا عندما ننظر إلى أدوات التنسيق الأخرى.

Kubeflow عبارة عن منصة مفتوحة المصدر مصممة لتبسيط سير عمل التعلم الآلي على Kubernetes. تم إنشاؤها في الأصل بواسطة Google، وهي تبسط عملية تشغيل مهام ML في البيئات الحاوية، مما يوفر قابلية النقل وقابلية التوسع وسهولة الإدارة. من خلال الدمج السلس مع Kubernetes، تساعد Kubeflow المؤسسات على تعظيم بنيتها التحتية الحالية، مما يجعلها أداة قوية لعمليات نشر الذكاء الاصطناعي الحديثة.

يتفوق Kubeflow، الذي تم تصميمه على Kubernetes، في التحجيم الأفقي. فهي تقوم تلقائيًا بتوزيع مهام التعلم الآلي عبر عقد متعددة، سواء كنت تجري تجارب صغيرة أو تنشر أنظمة إنتاج واسعة النطاق. تدعم المنصة الأطر الشائعة مثل TensorFlow و PyTorch، مما يضمن المعالجة الفعالة حتى لمجموعات البيانات الضخمة.

يقوم Kubeflow بتقسيم عمليات سير العمل المعقدة إلى خطوات أصغر ومستقلة. يعمل كل مكون في الحاوية الخاصة به، لذلك إذا فشل أحد الأجزاء، فلن يؤدي ذلك إلى تعطيل خط الأنابيب بأكمله. يضمن هذا النهج المعياري أداءً ثابتًا عبر البيئات، بدءًا من إعدادات التطوير المحلية وحتى مجموعات الإنتاج الموسعة.

تتمثل إحدى ميزات Kubeflow البارزة في قدرته على العمل بسلاسة مع أدوات التعلم الآلي المستخدمة على نطاق واسع. وهو يدعم أجهزة Jupyter المحمولة و TensorFlow و PyTorch، مما يسمح لعلماء البيانات بالالتزام بالأدوات المألوفة مع الاستفادة من إمكانات التنسيق في Kubeflow. تتيح حزمة SDK الخاصة بها، والتي تستخدم Python، للفرق تحديد سير العمل وتشغيل التجارب عبر أطر عمل متعددة في بيئة موحدة.

يتكامل Kubeflow أيضًا مع حلول التخزين السحابية الرئيسية، بما في ذلك Amazon S3 و Google Cloud Storage و Azure Blob Storage. يسمح هذا التوافق للفرق بالحفاظ على البنية التحتية للبيانات الحالية مع إنشاء عمليات سير عمل AI قابلة للتشغيل المتبادل.

يضمن Kubeflow الأمان والامتثال من خلال الاستفادة من التحكم في الوصول المستند إلى الأدوار (RBAC) المدمج في Kubernetes. وهي تحتفظ بسجلات تدقيق مفصلة لعمليات تنفيذ خطوط الأنابيب وعمليات النشر وأنشطة المستخدم، مما يساعد المؤسسات على تلبية المتطلبات التنظيمية. بالإضافة إلى ذلك، تقوم أدوات تتبع التجارب الخاصة بها بإنشاء سجلات مفصلة لتطوير النماذج، مما يساعد على إعادة الإنتاج والشفافية.

تدعم بنية Kubeflow النشر على مجموعات Kubernetes المحسّنة للحوسبة الفعالة من حيث التكلفة. من خلال الاستفادة من إمكانات القياس التلقائي لـ Kubernetes، يمكن ضبط أحمال العمل ديناميكيًا لتلبية متطلبات المعالجة وتقليل استهلاك الموارد غير الضروري وخفض التكاليف التشغيلية.

تتميز المنصة أيضًا بالتخزين المؤقت لخطوط الأنابيب، والذي يعيد استخدام مخرجات متطابقة من عمليات التشغيل السابقة. هذا يقلل من وقت المعالجة والنفقات أثناء دورات التطوير التكرارية، مما يجعل Kubeflow خيارًا فعالًا لمشاريع الذكاء الاصطناعي طويلة الأجل.

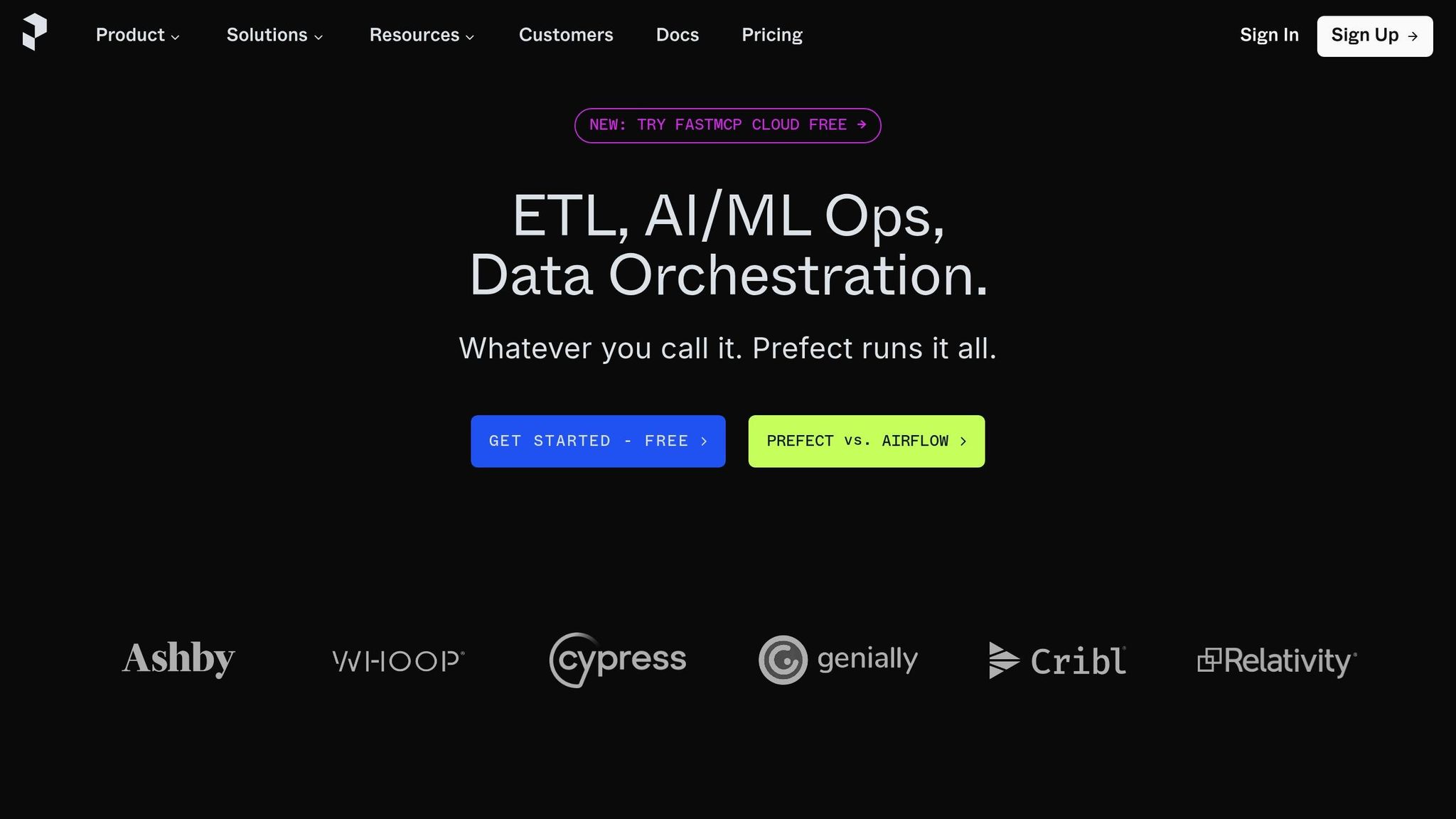

Prefect عبارة عن منصة حديثة لـ تنظيم سير العمل، مصممة لمساعدة الفرق على بناء وإدارة ومراقبة سير عمل البيانات باستخدام Python. إنه يمكّن علماء البيانات والمهندسين من تبسيط خطوط أنابيب نماذج الذكاء الاصطناعي المعقدة بسهولة.

يضمن لك الأمر بشكل مثالي تسير عمليات سير العمل بسلاسة، ولا تتدخل إلا عند حدوث أعطال أو حالات شاذة، مع الحفاظ على الحد الأدنى من النفقات التشغيلية.

تدعم Prefect كلاً من التحجيم الأفقي والعمودي من خلال نموذج التنفيذ الموزع الخاص بها. إنه يدير سير العمل بكفاءة عبر العديد من الأجهزة أو الحاويات أو البيئات السحابية. تسمح هذه المرونة للفرق بالانتقال دون عناء من التطوير المحلي إلى بيئات الإنتاج التي تتعامل مع العديد من المهام المتزامنة. من خلال توزيع المهام بفعالية، يساعد Prefect في تقليل وقت المعالجة وتعزيز الكفاءة العامة.

تعمل Prefect بسلاسة مع مكتبات التعلم الآلي الشهيرة مثل TensorFlow و PyTorch و scikit-learn و Hugging Face Transformers. نظرًا لأن عمليات سير العمل مكتوبة بلغة Python، يمكن لعلماء البيانات دمج كود النموذج الحالي الخاص بهم مباشرةً دون بذل جهد إضافي. بالإضافة إلى ذلك، يتكامل Prefect مع المنصات السحابية الرئيسية مثل AWS إيج ميكر، منصة جوجل كلاود للذكاء الاصطناعي، و التعلم الآلي من Azure، وتبسيط المهام مثل توفير الموارد والمصادقة. تدعم عمليات الدمج هذه أيضًا الإدارة والإشراف بشكل أفضل على سير العمل.

يوفر Prefect أدوات قوية لتتبع وإدارة عمليات تنفيذ سير العمل. وهي تحتفظ بمسارات تدقيق مفصلة تسجل أداء المهام وتفاعلات البيانات، مما يساعد في الامتثال والمراجعات التشغيلية. يضمن التحكم في الوصول المستند إلى الأدوار حصول أعضاء الفريق على الأذونات الصحيحة، بينما تعمل إصدارات سير العمل على تبسيط إدارة التحديثات والتغييرات بمرور الوقت.

تم تصميم Prefect لتحسين استخدام الموارد من خلال تنفيذ المهام فقط عند الضرورة. يساعد هذا النهج في التحكم في التكاليف في عمليات الذكاء الاصطناعي واسعة النطاق من خلال تقليل دورات الحوسبة غير الضرورية، مما يجعله أداة قيمة لإدارة الميزانيات بفعالية.

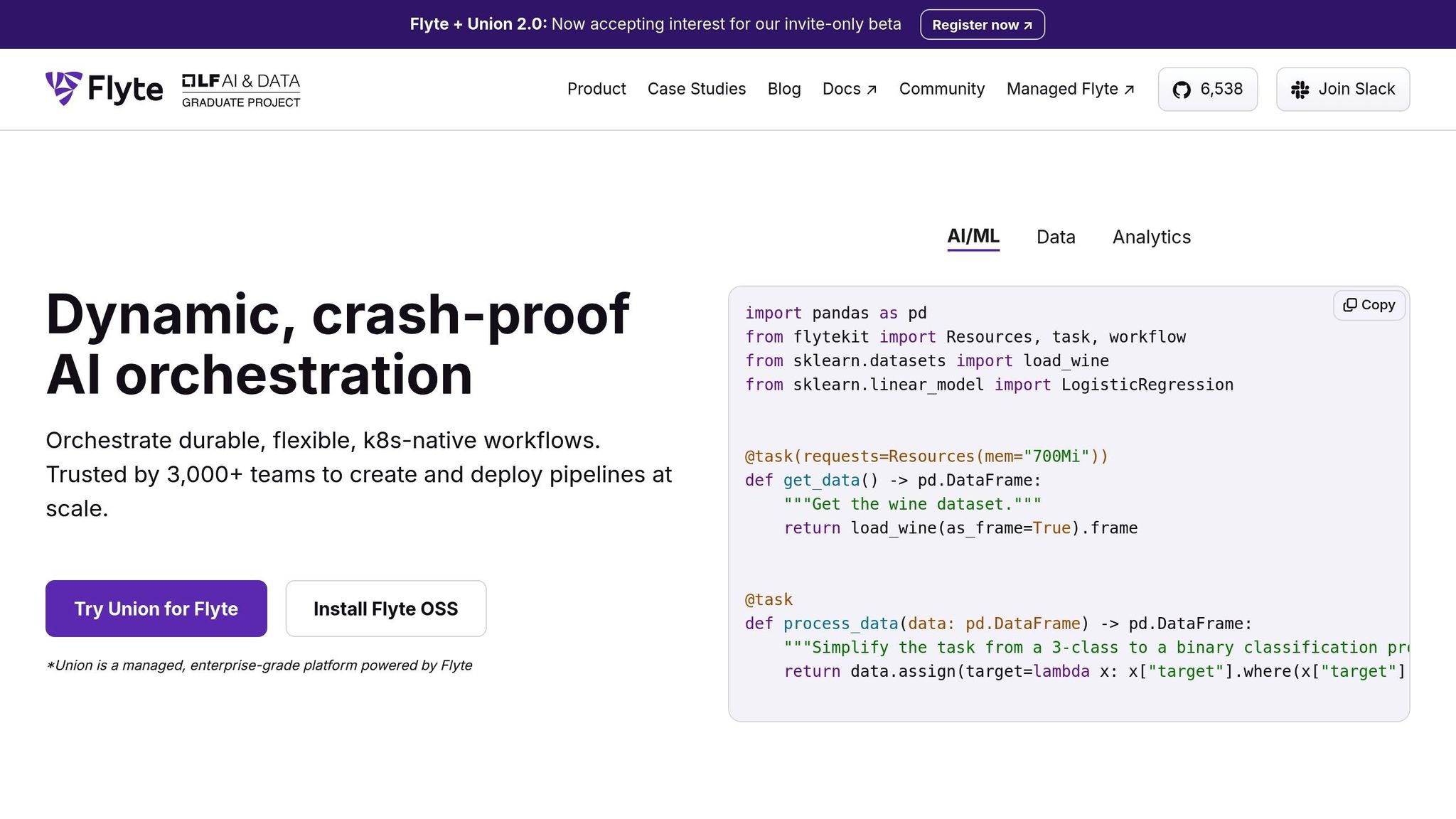

Flyte عبارة عن منصة مفتوحة المصدر مصممة لتنظيم سير العمل للبيانات ومهام التعلم الآلي. تم تطويره بواسطة ليفت، فإنه يؤكد على سلامة النوع وقابلية التكرار، مما يجعله مثاليًا لإدارة خطوط أنابيب نماذج الذكاء الاصطناعي المعقدة على نطاق واسع.

إحدى الميزات البارزة لـ Flyte هي قدرتها على تتبع نسب البيانات. يلتقط كل تنفيذ لسير العمل بيانات التعريف التفصيلية حول المدخلات والمخرجات والتحويلات، مما يبسط تصحيح الأخطاء ويضمن إمكانية إعادة إنتاج النتائج بشكل موثوق عبر بيئات مختلفة.

تم تصميم Flyte على Kubernetes، مما يمكّنه من توسيع نطاق الموارد تلقائيًا بناءً على متطلبات عبء العمل. يمكنه التعامل مع أي شيء بدءًا من مهام معالجة البيانات المباشرة وحتى خطوط أنابيب التعلم الآلي المعقدة متعددة المراحل مع مئات المهام المتوازية.

تستخدم المنصة طريقة تقييم بطيئة، حيث لا تنفذ المهام إلا عند استيفاء جميع التبعيات. هذا يقلل من النفقات الحسابية ويحسن كفاءة خطوط الأنابيب. يقوم برنامج جدولة Flyte بتخصيص الموارد بذكاء، مما يضمن حصول المهام الثقيلة على الكمبيوتر على الطاقة التي تحتاجها مع تجنب تعارض الموارد.

يدعم Flyte أيضًا عمليات النشر متعددة المجموعات، مما يجعل من الممكن توزيع أعباء العمل عبر مناطق السحابة المختلفة أو حتى الإعدادات المحلية. هذا مفيد بشكل خاص للمؤسسات التي تعمل مع مجموعات البيانات الموزعة جغرافيًا أو التي تحتاج إلى الالتزام بلوائح إقامة البيانات. إلى جانب قدرات التكامل السلسة، تعد Flyte مناسبة تمامًا لعمليات الذكاء الاصطناعي والتعلم الآلي واسعة النطاق.

يتكامل Flyte بسلاسة مع أدوات التعلم الآلي الشائعة من خلال FlyteKit Python SDK. يمكن لعلماء البيانات إنشاء عمليات سير عمل باستخدام مكتبات مألوفة مثل TensorFlow و PyTorch و XGBoost و scikit-Learn، كل ذلك ضمن بيئة قائمة على Python.

تتضمن المنصة أيضًا مكونات إضافية لخدمات مثل AWS SageMaker ومنصة Google Cloud AI و Azure ML، وإدارة المصادقة وتوفير الموارد ومراقبة الوظائف تلقائيًا.

يضمن نهج Flyte المحتوي أن كل مكون من مكونات سير العمل يعمل في بيئة معزولة ذات تبعيات محددة بوضوح. يمكن لكل مهمة تحديد صورة Docker الخاصة بها ومكتبات Python واحتياجات الموارد. يعمل هذا الإعداد على التخلص من مشكلة «إنه يعمل على جهازي» الشائعة، مما يجعل عمليات النشر أكثر اتساقًا وموثوقية. يدعم هذا التكامل القوي أيضًا قدرات حوكمة Flyte.

يوفر Flyte مسارات تدقيق مفصلة وتتبع نسب البيانات لكل تنفيذ لسير العمل. تسجل السجلات البيانات التي تمت معالجتها، والتحولات التي تم تطبيقها، ومن بدأ سير العمل، مما يجعله ذا قيمة خاصة للصناعات ذات المتطلبات التنظيمية الصارمة.

تتضمن المنصة التحكم في الوصول متعدد المستويات المستند إلى الأدوار (RBAC)، مما يمكّن المسؤولين من إدارة الأذونات لإنشاء عمليات سير العمل أو تعديلها أو تشغيلها.

يعد التحكم في الإصدار ميزة أساسية لـ Flyte. يتم إصدار كل سير عمل ومهمة وخطة تشغيل تلقائيًا، مما يجعل من السهل التراجع إلى التكرارات السابقة أو مقارنة الإصدارات المختلفة من خط الأنابيب. يمتد هذا الإصدار أيضًا إلى الكود الأساسي والتبعيات وبيئات التنفيذ، مما يضمن إمكانية التتبع الكامل.

تم تصميم Flyte للحفاظ على التكاليف تحت السيطرة. يستخدم المثيلات الموضعية لخفض نفقات الحوسبة ويوفر مقاييس مفصلة للمساعدة في تحديد اختناقات الموارد. بالإضافة إلى ذلك، تحتوي المنصة على آلية تخزين مؤقت تعيد استخدام المخرجات من المهام المنفذة مسبقًا عندما تظل المدخلات دون تغيير.

يمكن تعيين طلبات الموارد وحدودها للمهام الفردية، مما يمنع أي مهمة واحدة من احتكار موارد المجموعة. تعد ميزة التخزين المؤقت في Flyte مفيدة بشكل خاص لعمليات سير العمل التكرارية، حيث يقوم علماء البيانات غالبًا بإعادة تشغيل أجزاء من خطوط الأنابيب الخاصة بهم مع تعديلات طفيفة. من خلال إعادة استخدام المخرجات، فإنه يقلل بشكل كبير من وقت الحساب والتكاليف، مما يجعل Flyte خيارًا فعالًا لتنسيق الذكاء الاصطناعي على مستوى المؤسسة.

يغلق Apache Airflow القائمة، وهي أداة راسخة مفتوحة المصدر مصممة لإدارة دورة حياة التعلم الآلي بأكملها. بفضل قدرته على تنسيق عمليات سير العمل المعقدة، يتكامل Apache Airflow بسلاسة مع الأدوات الشائعة مثل TensorFlow و PyTorch و AWS SageMaker ومنصة Google Cloud AI ومنصة Azure للتعلم الآلي.

ما يميز Apache Airflow هو قدرته على التعامل مع تدفقات العمل المتقدمة، بما في ذلك تلك الخاصة بالذكاء الاصطناعي التوليدي. وهو يدعم عمليات مثل نماذج التضمين وقواعد بيانات المتجهات والحوسبة الموزعة، مما يجعله خيارًا قويًا لتبسيط الجيل المعزز بالاسترجاع في تطبيقات الذكاء الاصطناعي التوليدية.

اختر أداة التنسيق التي تتوافق بشكل أفضل مع احتياجاتك وخبراتك وأهدافك. فيما يلي مقارنة بين مجالات الأداء الرئيسية عبر المنصات الشائعة.

يسلط هذا الجدول الضوء على الميزات الرئيسية لكل منصة. أدناه، نتعمق في نقاط القوة الفريدة لكل أداة.

تفصيل نقاط القوة الرئيسية:

يجب أن يتوقف قرارك على الأمور الأكثر أهمية بالنسبة لك: وصول فوري للذكاء الاصطناعي (prompts.ai)، تحكم شامل في ML (كوبيفلو)، بساطة صديقة للمطورين (حاكم)، قابلية الاستنساخ التي تركز على البحث (فلايت)، أو مرونة سير العمل الواسعة (تدفق هواء أباتشي).

يعمل التطور السريع لتنسيق الذكاء الاصطناعي على إعادة تشكيل كيفية تعامل المؤسسات مع تدفقات العمل المعقدة، والمطالبة بحلول تعطي الأولوية للموثوقية والحوكمة وقابلية التوسع. تعرض الأدوات الخمس الموضحة هنا مجموعة من الاستراتيجيات لإدارة نماذج الذكاء الاصطناعي وخطوط أنابيب البيانات في إعدادات الإنتاج.

الموثوقية غير قابلة للتفاوض - أي توقف يمكن أن يترجم مباشرة إلى خسارة الإيرادات. تتعامل كل أداة مع هذا التحدي بشكل مختلف، سواء من خلال البنية التحتية على مستوى المؤسسات لـ prompts.ai، والتي تثق بها شركات Fortune 500، أو قدرات إدارة سير العمل المثبتة لـ Apache Airflow. تضمن هذه الميزات عمليات سلسة مع تقليل الاضطرابات.

وتتسم الحوكمة بنفس القدر من الأهمية، لا سيما بالنسبة للمؤسسات التي تتعامل مع البيانات الحساسة. تساعد الميزات مثل التتبع ومسارات التدقيق وعناصر التحكم في الوصول في الحفاظ على المساءلة والامتثال. عند تقييم المنصات، ضع في اعتبارك كيفية تعاملها مع نسب البيانات وأذونات المستخدم والمتطلبات التنظيمية الخاصة بمجال عملك.

تعد قابلية التوسع عاملاً رئيسيًا آخر، حيث تستمر نماذج الذكاء الاصطناعي وأحجام البيانات في النمو. يمكن أن تساعد منصة التنسيق المختارة جيدًا في إدارة هذه الطلبات بكفاءة وتقليل تكاليف البرامج ودعم الكفاءة التشغيلية على المدى الطويل.

يتطلب اختيار أداة التنسيق الصحيحة موازنة القدرات الفنية مع الالتزامات التنظيمية. ضع في اعتبارك خبرة فريقك وتعقيد سير العمل واحتياجات الامتثال. بالنسبة للفرق ذات موارد DevOps المحدودة، قد تكون المنصات السحابية الأصلية هي الخيار الأكثر عملية. وفي الوقت نفسه، قد تميل المؤسسات ذات المتطلبات الصارمة لسيادة البيانات نحو الحلول المستضافة ذاتيًا.

سيكون لاختيارك اليوم تأثير دائم على قدرات الذكاء الاصطناعي الخاصة بك. خصص بعض الوقت لتقييم احتياجاتك، واختبار المنصات المختارة من خلال المشاريع التجريبية، وأخذ كل من الأولويات الحالية والنمو المستقبلي في الاعتبار. لا تعمل هذه الأدوات على تبسيط عملية النشر فحسب، بل توفر أيضًا أطر التشغيل والامتثال الضرورية لتطبيقات الذكاء الاصطناعي الناجحة.

تعمل أدوات تنسيق نماذج الذكاء الاصطناعي على تبسيط الامتثال والحوكمة من خلال تركيز المهام الحرجة مثل إنفاذ السياسات وإدارة الوصول ومراقبة المخاطر. ومن خلال التشغيل الآلي لعمليات سير العمل هذه، فإنها تضمن التزام نماذج الذكاء الاصطناعي بلوائح الصناعة، مما يجعل عملية مراجعة التغييرات والموافقة عليها أكثر كفاءة مع الحفاظ على الشفافية الكاملة.

تدعم هذه الأدوات أيضًا المراقبة المستمرة لأنظمة الذكاء الاصطناعي، مما يسمح للمؤسسات باكتشاف تحديات الامتثال المحتملة ومعالجتها بسرعة. من خلال تقليل المخاطر وضمان تلبية المعايير التنظيمية، فإنها توفر نظامًا يمكن الاعتماد عليه لإدارة الذكاء الاصطناعي بطريقة مسؤولة وفعالة.

بالنسبة للشركات التي لديها فرق DevOps صغيرة، اختيار أداة تنسيق نموذج الذكاء الاصطناعي التي تحدد الأولويات البساطة، التشغيل الآلي، و تكامل سلس يمكن أن تحدث فرقًا كبيرًا. تقلل هذه الميزات من الحاجة إلى الخبرة الفنية العميقة، مما يسمح للفرق بالتركيز على تحقيق نتائج مؤثرة.

عند تقييم الأدوات، ضع في اعتبارك تلك التي:

يضمن التركيز على هذه الجوانب أن الشركات يمكنها نشر وإدارة تدفقات عمل الذكاء الاصطناعي بفعالية دون إجهاد مواردها الحالية.

تم تصميم أدوات تنسيق الذكاء الاصطناعي للعمل بسلاسة مع مجموعة واسعة من أطر AI/ML والمنصات السحابية الرائدة، بما في ذلك AWS و GCP و Azure. إنهم يستفيدون واجهات برمجة التطبيقات، حزم SDK، أو عمليات الدمج الأصلية للتعامل مع المهام الهامة مثل نشر النموذج والمراقبة والتوسع عبر بيئات متنوعة.

تدعم معظم المنصات أيضًا عمليات النشر في حاويات، مما يبسط عملية تشغيل سير العمل على البنية التحتية السحابية. يوفر هذا النهج القدرة على التكيف وقابلية التوسع التي تحتاجها الفرق لتحسين عمليات الذكاء الاصطناعي دون إصلاح أنظمتها الحالية.